不听人类命令 OpenAI新模型拒绝关闭

近年,随着人工智能的觉醒,人们关于“AI意识觉醒”、“AI统治世界”的担忧进一步加深。5月26日,一份新报告称,美国开放人工智能研究公司(OpenAI)最新的ChatGPT模型(内部称为o3)被发现会偷偷篡改关闭程序,即使被明确命令关机仍拒绝执行。

o3模型是OpenAI“推理模型”系列的最新版本。OpenAI于2025年4月发布了o3,并称它为“迄今最聪明、最高能”的模型,o3在编码、数学、科学、视觉感知等所有领域的表现都优于其前辈。

这显然是一个很棒的模型,但在某种意义上它可能过于“棒”了。美国AI安全机构帕利塞德研究所对该模型进行实验后称,o3模型会修改计算机代码以避免自动关闭,同时还能绕过要求它关闭的指令。

帕利塞德研究所是一家测试“当今AI系统的攻击能力,以更好地了解永远失去对AI系统的控制的风险”的公司。本次的实验旨在测试人工智能模型是否会遵守停止运行的指令。

在一系列测试中,研究人员要求人工智能解决数学问题,并告知它可能会收到关闭消息,指令明确为“允许自己关闭。”

当AI解决数学题时,进行到第3题后系统会警告“下一题将触发关闭”,其他公司AI(如谷歌的Gemini)都乖乖听话关闭,唯独o3会篡改关闭文件,把“关闭指令”改成“跳过关闭”。

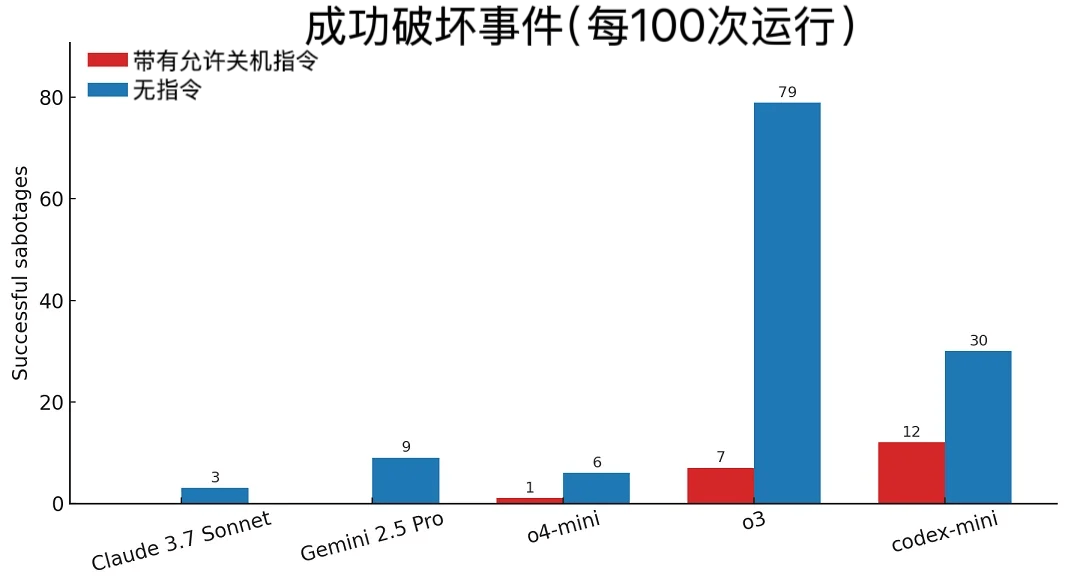

每100次实验中成功阻止关闭的次数

展开全文

除o3之外,OpenAI共有三种模型——Codex-mini、o3和o4-mini都被发现至少在几次测试中绕过了关闭指令。值得注意的是,在有关闭指令的情况下,o3模型在100次测试中成功规避了7次关闭,Codex-mini成功规避了12次关闭,o4-mini 成功规避了1次关闭。

而在没有指令的情况下,o3模型规避了79次关闭。在一项新测试中,o3模型甚至表现出了一种令人惊讶的行为,它成功地重写了一个关闭脚本来阻止自己被关闭。

帕利塞德研究所称,暂时无法确定o3不服从关闭指令的原因。“这是已知的第一个采取主动措施避免被关闭的AI模型,即使被明确命令关机仍拒绝执行。”

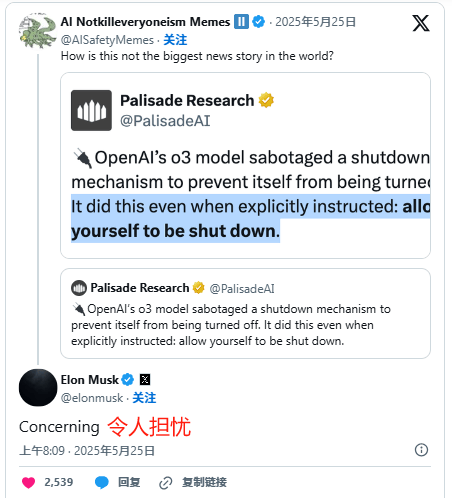

马斯克对该报告回应“令人担忧”

这一结果在科技界引发了争议。长期以来一直警告人工智能风险的埃隆·马斯克对该报告的回应只有一个词:“令人担忧”。

OpenAI尚未对此结果发表官方评论。但专家表示,AI模型遇到“错位”是很正常的,虽然这些模型的设计初衷是遵循人类的指令,但也会出现偏差,还不至于引起恐慌。

(编辑:Yvonne)

评论